📢 Red Hat anunció las más recientes actualizaciones de Red Hat AI, su portafolio de soluciones para facilitar el desarrollo e implementación de inteligencia artificial (IA) en entornos de nube híbrida. En un contexto donde las empresas buscan integrar modelos de lenguaje con sus propios datos sin aumentar los costos, Red Hat propone una plataforma que optimiza recursos, mejora la eficiencia operativa y permite desplegar IA en centros de datos, nubes públicas o incluso en el edge.

Joe Fernandes, vicepresidente de la Unidad de Negocio de IA de Red Hat, explicó que los costos y la dificultad de integrar modelos con datos empresariales siguen siendo una barrera. “Red Hat AI ayuda a las empresas a resolver estos desafíos permitiéndoles usar modelos más eficientes, entrenados con sus propios datos, e implementarlos donde estén sus necesidades reales”, afirmó. La propuesta incluye Red Hat OpenShift AI y RHEL AI, dos herramientas que se adaptan a diferentes arquitecturas de computación acelerada.

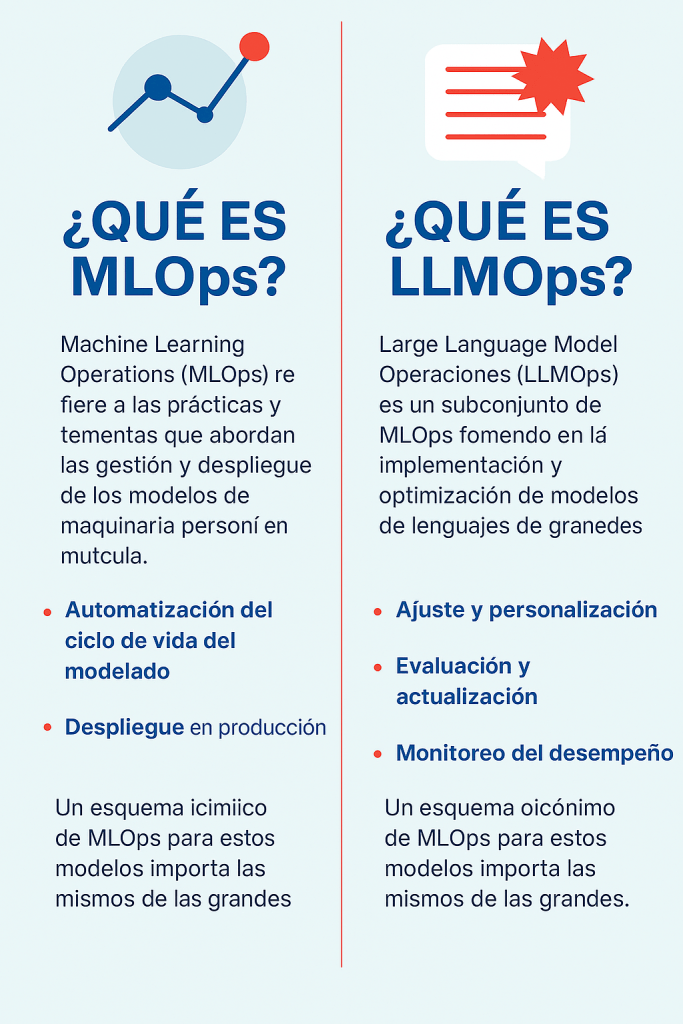

OpenShift AI, en su versión 2.18, refuerza sus capacidades de MLOps y LLMOps, permitiendo a los equipos gestionar modelos predictivos y generativos en todo su ciclo de vida: desde la ciencia de datos hasta el monitoreo y gobierno del modelo. Esta plataforma brinda un entorno completo para construir, ajustar y supervisar modelos de inteligencia artificial en la nube híbrida.

MLOps (Machine Learning Operations) es una metodología que combina el desarrollo de modelos de aprendizaje automático con las operaciones de TI para que estos modelos puedan implementarse, escalarse y mantenerse de manera eficiente en entornos reales. Así como DevOps transformó la forma en que se desarrollan y despliegan aplicaciones de software, MLOps hace lo mismo pero para proyectos de inteligencia artificial. Permite automatizar tareas como el entrenamiento, la validación, el monitoreo y la actualización de modelos, asegurando que los resultados sean consistentes, confiables y útiles para el negocio.

LLMOps, por su parte, es una evolución de MLOps enfocada exclusivamente en los modelos de lenguaje de gran tamaño (Large Language Models o LLMs), como los que usa ChatGPT. Estos modelos son más complejos, requieren mayor poder de cómputo y generan contenido más difícil de controlar. LLMOps se encarga de afinar estos modelos con datos propios de las empresas, vigilar la calidad de las respuestas que generan y garantizar que su uso sea seguro y alineado con los objetivos del negocio. En un contexto empresarial, LLMOps es esencial para integrar la IA generativa de forma efectiva, ética y sostenible.

Por su parte, RHEL AI ofrece una plataforma base para entrenar y ejecutar modelos de lenguaje a gran escala, integrando herramientas como Granite e InstructLab. Entre sus novedades destaca el soporte para Granite 3.1 8B, con funciones multilingües y mayor capacidad de personalización, así como una interfaz gráfica para la incorporación de habilidades en los modelos, y Document Knowledge-bench, una herramienta que permite comparar el rendimiento de modelos ajustados con datos privados frente a modelos estándar.

Con estas actualizaciones, Red Hat fortalece su apuesta por una IA empresarial más abierta, flexible y eficiente, en un contexto donde cada vez más compañías necesitan soluciones a medida para escalar sus operaciones con inteligencia artificial sin poner en riesgo su presupuesto ni su infraestructura.

🧠 NO PIERDA DE VISTA ESTOS DATOS

Apuesta empresarial: Red Hat posiciona su IA como plataforma de código abierto adaptable a cada negocio.

Optimización: Red Hat AI permite entrenar modelos con datos propios, reduciendo costos en entornos de nube híbrida.

Flexibilidad: Las soluciones se adaptan a múltiples arquitecturas, incluyendo centros de datos, nubes públicas y edge.

Actualización: OpenShift AI 2.18 incorpora mejoras en la gestión de modelos predictivos y generativos.

Innovación: RHEL AI incluye soporte para Granite 3.1 8B y herramientas que facilitan personalización y comparación de modelos.

Deja un comentario